BLOG

JetCool lanza una nueva CDU que puede enfriar hasta 300 kW

La empresa de refrigeración líquida JetCool ha lanzado una nueva unidad de distribución de refrigerante (CDU).

La CDU SmartSense está disponible como unidad en rack y como unidad modular.

JetCool afirma que cada unidad tiene una capacidad de hasta 300 kW. El sistema es escalable hasta 2,1 MW en configuraciones por hilera.

La empresa se especializa en "tecnología de enfriamiento microconvectivo", lo que significa que los chorros de enfriamiento dirigen el fluido directamente a la superficie de un chip en lugar de pasarlo sobre él.

La cartera de productos de JetCool también incluye soluciones de refrigeración por aire y placas frías.

Es propiedad de Flex, fabricante estadounidense de servicios de fabricación de productos electrónicos y diseño original. La adquisición se realizó en noviembre de 2024. No se anunciaron los términos del acuerdo.

Nvidia trabaja con socios de centros de datos para construir sistemas de energía HVDC de 800 V

Nvidia está colaborando con empresas de equipos para centros de datos para desarrollar nuevos sistemas de energía que respalden los nuevos racks de más de 1 MW.

Utilizando corriente continua de alto voltaje (HVDC) de 800 V, esta nueva arquitectura centralizará la distribución de energía en los centros de datos de IA, lo que permitirá convertir la energía de CA a CC en el nivel de la GPU, dentro de la placa del servidor, minimizando las pérdidas de energía.

Los socios del proyecto incluyen a Infineon, STMicroelectronics y Texas Instruments para el silicio; Delta y Flex Power para los componentes del sistema de energía; y Eaton, Schneider Electric y Vertiv para los sistemas de energía del centro de datos.

La compañía afirmó que su arquitectura HVDC de 800 V aborda estos desafíos a través de un "rediseño holístico", eliminando la necesidad de las múltiples conversiones de voltaje que tienen lugar en varias etapas entre la red y el rack y liberando "espacio valioso para más recursos informáticos, lo que permite configuraciones de mayor densidad y una mejor eficiencia de refrigeración".

Según Nvidia, su enfoque podría resultar en una mejora de hasta un cinco por ciento en la eficiencia energética de extremo a extremo y reducir los costos de mantenimiento hasta en un 70 por ciento, las fallas de la unidad de suministro de energía y los costos laborales más bajos para el mantenimiento de los componentes.

Los costos de enfriamiento también podrían reducirse quitando las unidades de suministro de energía CA/CC del interior de los racks.

OpenAI abrirá el primer centro de datos internacional Stargate en los Emiratos Árabes Unidos

OpenAI ha presentado su primer despliegue internacional de Stargate, con planes de abrir un centro de datos de 1 GW en los Emiratos Árabes Unidos (EAU).

El proyecto reunirá a OpenAI con sus socios de Stargate G42, Oracle, Nvidia, Cisco y SoftBank para impulsar cargas de trabajo de IA en los Emiratos Árabes Unidos, y el país rico en efectivo también invertirá en el proyecto.

Stargate UAE prevé entrar en funcionamiento en 2026 con una potencia inicial de 200 MW. No se ha especificado una fecha para la puesta en marcha completa de 1 GW.

Si bien los Emiratos Árabes Unidos fueron los primeros en participar en el proyecto OpenAI for Countries, el equipo detrás del proyecto quiere 10 instalaciones en total.

En un intento por encontrar sus próximos sitios, el director de estrategia de OpenAI, Jason Kwon, comenzará un viaje por carretera a través de Asia Pacífico la próxima semana con planes de reunirse con gobiernos y posibles socios del sector privado.

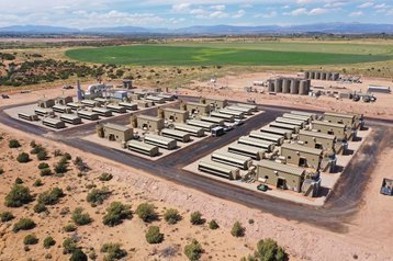

Crusoe obtiene 11.600 millones de dólares en deuda y capital para el campus del centro de datos Stargate de OpenAI en Abilene, Texas.

Crusoe ha recaudado la segunda fase de su empresa conjunta de 15 mil millones de dólares para financiar un campus de centro de datos de inteligencia artificial de 1,2 GW en Abilene, Texas.

La compañía obtuvo $11.6 mil millones en deuda y capital para el sitio, con los fondos administrados por la plataforma Real Assets de Blue Owl junto con Primary Digital Infrastructure.

El campus es el sitio insignia del proyecto Stargate de OpenAI, un proyecto de 500 mil millones de dólares para construir una serie de centros de datos masivos en todo Estados Unidos para el desarrollador de IA.

Cada uno de los ocho edificios operará hasta 50.000 Nvidia GB200 NVL72 en una única red integrada, según Crusoe. Los centros de datos utilizarán refrigeración líquida directa al chip mediante sistemas de refrigeración sin evaporación de agua que recirculan el agua a través de un sistema de circuito cerrado.

El campus en sí es parte del Lancium Clean Campus, propiedad de Lancium.

Flexential se asocia con UPenn para la implementación de Nvidia DGX B200 SuperPOD en el centro de datos de Collegeville

El operador de centros de datos estadounidense Flexential ha anunciado la implementación gradual de un Nvidia DGX SuperPOD para respaldar el lanzamiento del nuevo Centro de Computación de Investigación Avanzada de Pensilvania (PARCC) de la Universidad de Pensilvania (UPenn).

Compuesto por sistemas DGX B200 y una solución de red Nvidia Quantum-2 InfiniBand, el sistema estará alojado en el centro de datos de Flexential en Collegeville, Pensilvania.

En una declaración, Flexential afirmó que la implementación respaldaría los requisitos de infraestructura de alta densidad de PARCC y agregó que la instalación había sido diseñada para satisfacer las demandas de rendimiento y eficiencia de las cargas de trabajo de inteligencia artificial a gran escala y computación de alto rendimiento, y certificada como parte del programa Nvidia DGX-Ready Data Center.

El proveedor de servicios de TI empresariales Ahead fue responsable de la integración de racks externos y del cableado local, entregando racks preconfigurados a las instalaciones para reducir el tiempo de configuración y la complejidad de la instalación.

Ubicado a 40 kilómetros al noroeste del campus de la Universidad de Pensilvania en Filadelfia, el centro de datos de Flexential en Collegeville ofrece 7,2 MW de capacidad en sus 18 925 m² (203 705 pies cuadrados). La empresa afirmó que las instalaciones cuentan con refrigeración líquida integrada y mantienen acuerdos de nivel de servicio (SLA) del 100 % en energía, refrigeración, red y ancho de banda, además de suministrar más de 1500 vatios por pie cuadrado.

GI fundó Flexential en 2017 tras la fusión de Peak 10 y ViaWest. GI adquirió Peak 10 en 2014. Morgan Stanley también es inversor. Actualmente, Flexential opera 40 centros de datos en 18 mercados estadounidenses y cuenta con más de 330 MW de capacidad construida y en desarrollo.

La saudí DataVolt firma un acuerdo de 20.000 millones de dólares con Supermicro

La empresa de centros de datos de Arabia Saudita DataVolt ha firmado un acuerdo de 20 mil millones de dólares con Super Micro Computer (Supermicro).

El acuerdo, descrito como una asociación de varios años, verá a Supermicro entregar plataformas GPU y sistemas de rack a los "campus de IA de hiperescala" de DataVolt en Arabia Saudita y Estados Unidos.

Charles Liang, director ejecutivo de Supermicro, añadió: «Nos entusiasma asociarnos con DataVolt y seguir expandiendo nuestra producción en Estados Unidos. Colaborando, aportaremos una infraestructura de inteligencia artificial y computación de vanguardia, lo que hará realidad la visión del Reino de convertirse en un centro global de tecnología e innovación».

Este año hasta el momento, DataVolt ha anunciado planes para dos nuevos centros de datos en Arabia Saudita: una instalación en Riad y otro campus de 1,5 GW en Oxagon de Neom.

La empresa se ha comprometido a invertir más de 5 mil millones de dólares en el desarrollo de alrededor de 300 MW de capacidad de centros de datos en el país y anteriormente anunció planes para centros de datos en Dhaka, Bangladesh y Uzbekistán.

Si bien el comité informó en diciembre de 2024 que no encontró "evidencia de fraude o mala conducta" por parte de la gerencia o la junta, recomendó que Supermicro reemplazara a su director financiero, un proceso que la compañía dijo haber iniciado, y el actual director financiero, David Weigand, conservaría el cargo hasta que se encuentre un nuevo candidato.

Nvidia lanza NVLink Fusion para conectar CPU y ASIC personalizados con hardware de Nvidia

Nvidia ha abierto su tecnología de interconexión NVLink a empresas externas, con el lanzamiento de NVLink Fusion.

Presentada esta semana en Computex en Taiwán, la nueva oferta permite a los clientes construir una infraestructura de IA semipersonalizada que vincula aceleradores que no son de Nvidia con hardware de Nvidia en soluciones a escala de rack.

Los proveedores de la nube también podrán usar NVLink Fusion para ampliar las fábricas de IA a “millones de GPU”, utilizando cualquier ASIC en combinación con los sistemas a escala de rack y la plataforma de red de Nvidia.

NVLink de Nvidia proporciona tecnología de interconexión de alto rendimiento que se ubica entre la GPU y la CPU, lo que permite un intercambio de datos mucho más rápido.

La plataforma NVLink, actualmente en su quinta generación, ofrece 800 Gbps de rendimiento e incluye SuperNIC ConnectX-8, conmutadores Spectrum-X y Quantum-X800 InfiniBand, y próximamente será compatible con ópticas integradas. Además, puede proporcionar un ancho de banda total de 1,8 Tbps por GPU, 14 veces más rápido que PCIe Gen5, según Nvidia.

Su primera especificación de interconexión de GPU se lanzó en abril de 2025, proporcionando un rendimiento de 200 Gbps por carril y conectando hasta 1024 aceleradores por módulo.

Los servicios y soluciones de diseño de silicio NVLink Fusion están disponibles ahora en MediaTek, Marvell, Alchip, Astera Labs, Synopsys y Cadence.

Nvidia y Foxconn planean una supercomputadora de inteligencia artificial taiwanesa

Nvidia y Foxconn están trabajando con el gobierno taiwanés para construir una supercomputadora de inteligencia artificial.

Anunciada por Nvidia en Computex en Taiwán, la supercomputadora constará de 10.000 GPU Nvidia Blackwell Ultra, con Big Innovation Company (una subsidiaria de Foxconn y socio en la nube de Nvidia) proporcionando la infraestructura de IA.

Los sistemas Blackwell incluidos en la supercomputadora incluirán el GB300 NVL72, conectado mediante NVLink, Nvidia Quantum InfiniBand y redes Ethernet Nvidia Spectrum-X.

Según Nvidia, el Consejo Nacional de Ciencia y Tecnología de Taiwán utilizará el sistema para proporcionar recursos de computación en la nube con IA a las industrias de todo Taiwán. Los investigadores de TSMC también tendrán acceso a la supercomputadora, mientras que Foxconn la utilizará para acelerar la automatización y la eficiencia en sus tres pilares fundamentales: ciudades inteligentes, vehículos eléctricos y manufactura.

Young Liu, presidente y director ejecutivo de Foxconn, agregó: “Foxconn crea tecnología que sustenta la vida moderna y ahora estamos construyendo infraestructura informática para escalar la próxima generación de avances en todo Taiwán.

Se produce un incendio en un centro de datos de Oregón alquilado por X de Elon Musk

El jueves 22 de mayo se produjo un incendio en un centro de datos de Hillsboro, Oregón, alquilado por la empresa de redes sociales X de Elon Musk, lo que provocó un importante apagón mundial.

Según informó Wired, los bomberos llegaron al Parque Tecnológico de Hillsboro a las 10:21 am para lidiar con el brote.

Según el informe de Wired, el incendio estaba relacionado con una sala de baterías. Piseth Pich, portavoz del Departamento de Bomberos y Rescate de Hillsboro, afirmó que el fuego no se había propagado a otras partes del edificio, pero que la sala estaba llena de humo.

Según Wired, X alquila espacio en un edificio de centro de datos "vinculado" a Digital Realty.

En una declaración escrita a la publicación local Oregon Live, Digital Realty afirmó sobre el incendio: "El incidente está bajo control y el departamento de bomberos ha concluido su respuesta en el lugar. Todo el personal fue evacuado de forma segura, sin que se reportaran heridos".

Digital Realty se negó a decir si X alquila espacio en las instalaciones directamente afectadas por el incendio.

A finales de 2022, Musk cerró el centro de datos de Sacramento y trasladó hasta 2573 racks de servidores a centros de datos en Portland y Atlanta. En torno a ese momento, X sufrió una interrupción de siete horas. Posteriormente, Tesla asumió el arrendamiento del sitio.

Los centros de datos de Digital Realty en Portland, Oregón, tienen una superficie total de 56.500 metros cuadrados (609.000 pies cuadrados) divididos entre dos centros de datos.

GlobalWafers abre una fábrica de obleas en Sherman, Texas, y planea una inversión adicional de 4.000 millones de dólares en EE. UU.

El fabricante de chips taiwanés GlobalWafers ha anunciado planes para invertir 4.000 millones de dólares adicionales en Estados Unidos.

Los comentarios fueron hechos por Doris Hsu, presidenta y CEO de GlobalWafers, en la inauguración de la nueva fábrica de US$3.500 millones de la compañía en Sherman, Texas.

GlobalWafers recibirá 406 millones de dólares en financiación directa de la ley CHIPS del gobierno estadounidense para apoyar la construcción de dos fábricas, la recién inaugurada en Sherman, Texas, y una segunda en St. Peters, Missouri, ambas producirán obleas de 300 mm y obleas de silicio sobre aislante.

La empresa también está planeando convertir su actual planta de fabricación de obleas de epitaxia de silicio en Sherman en un sitio de fabricación de obleas de epitaxia de carburo de silicio (SiC), produciendo obleas de epitaxia de SiC de 150 mm y 200 mm.

El campus de 142 acres en Texas puede albergar hasta seis fases. No se ha establecido un cronograma para estas fases adicionales.

Tras ese anuncio, en marzo, TSMC anunció que invertiría 100 mil millones de dólares en Estados Unidos (sin que esté claro qué parte de la cifra anterior está incluida en el número) después de que el presidente Trump criticara a Taiwán por "robar" el negocio de chips de Estados Unidos, dijera que la Ley CHIPS era un fracaso y amenazara con aranceles.

Deja una respuesta

LOGO

Esta impresionante propiedad de casa de playa es un verdadero oasis, ubicado en una serena comunidad costera con acceso directo a la playa.

Horario de apertura

Lunes - Viernes: 9:00 a 17:00 horas

Domingo: Cerrado

Cerrado durante las vacaciones

Contacto

+18888888888

hezuo@eyingbao.com123 West Street, Melbourne Victoria 3000 Australia